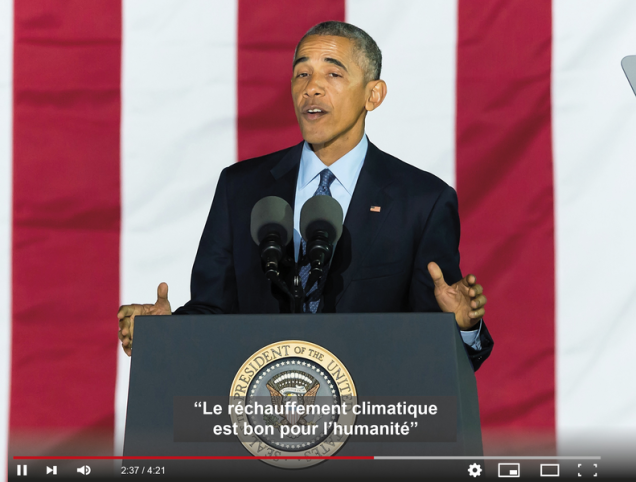

Barack Obama traitant publiquement Donald Trump d’ « abruti total et absolu » : la vidéo n’est pas passée inaperçue lorsqu’elle a été publiée en avril dernier par le site américain Buzzfeed. Durant un peu plus d’une minute, l’ancien président des États-Unis explique, face caméra, que « nous entrons dans une ère où nos ennemis peuvent faire croire que n'importe qui dit n'importe quoi à n'importe quel moment ». La voix est bien la sienne, ses lèvres bougent de façon synchronisée à mesure qu’il prononce ces mots. Sauf que tout est faux. Cette vidéo a été créée de toute pièce par Buzzfeed en association avec l’acteur américain Jordan Peele, qui prononce les mots attribués à Obama.

Bienvenue dans le monde des deepfakes, ces vidéos falsifiées grâce à des outils d’intelligence artificielle. En faisant prononcer les propos de son choix à la personne de son choix, elles pourraient bien porter le phénomène des fake news à son paroxysme. « Les deepfakes – dont le terme est issu de la contraction de deep learning et de fake news – vont changer notre rapport à la vidéo. On savait que les images pouvaient être manipulées ; avec les deepfakes, nous aurons besoin d’un temps d’adaptation pour intégrer que les vidéos ne correspondent pas forcément à la réalité », explique Vincent Claveau, chercheur au CNRS et à l’Irisa.

Des mots pour un autre

Plusieurs techniques différentes, élaborées dans des laboratoires de recherche à partir de réseaux de neurones profonds (le deep learning), peuvent servir à créer ce type de vidéos. Ainsi le « face-to-face » permet de remplacer le visage de quelqu’un par celui d’un autre, de façon parfois très réaliste et donc indécelable à l’œil nu. Les premières vidéos utilisant cette technique sont apparues dans l’industrie du porno. C’est ainsi que l’actrice Gal Gadot, star du film Wonder Woman, s’est retrouvée à son insu dans un film X, un cas parmi des centaines d'autres. D’autres logiciels intelligents permettent de reconstituer n'importe quelle voix et ainsi lui faire dire ce qu’on veut. Un autre propose, à partir d’un fichier audio, de créer une vidéo dans laquelle le mouvement des lèvres de la personne qui parle est synchronisé avec le son.

« Pour l’instant, nous ne disposons que de bribes de technologies, qui mises bout à bout permettent de créer des fakes beaucoup plus crédibles. C’est la combinaison de plusieurs de ces technologies qui fait peur. D’autant que les progrès en matière d’intelligence artificielle ne vont qu’améliorer la qualité de ces vidéos », anticipe Denis Teyssou, responsable éditorial du Medialab R&D de l’AFP et responsable de l’innovation du projet européen InVID, dont l’objectif est d’aider les journalistes à détecter les fausses images. Pour Mathieu Aubry, chercheur à l’École des Ponts ParisTech et spécialiste en vision artificielle, « cela fait longtemps que les gens essaient de générer de fausses vidéos ; ce qui est plus récent, c’est qu’on arrive à le faire de façon réaliste ».

Un processus exigeant

Pour autant, le raz-de-marée des deepfakes n’est pas encore pour aujourd’hui, loin de là. « Ces technologies sortent des laboratoires ; elles requièrent un certain niveau de connaissances informatiques et scientifiques, même si cela va aller en s’améliorant », remarque Vincent Claveau. Selon le chercheur, un autre problème se pose : la disponibilité des données. « Les réseaux de neurones ont besoin d’être entraînés pour pouvoir associer tel mouvement de lèvres à tel son. Il faut beaucoup de matériaux pour pouvoir créer une vidéo. » Dans le cas de personnalités moins connues que Barack Obama par exemple, ces données ne sont pas toujours disponibles en quantité suffisante, ce qui pourra freiner le développement des deepfakes.

D’où l’émergence de techniques moins élaborées, qui consistent par exemple à insérer sur un visage la bouche d’une autre personne, histoire que les lèvres suivent bien le mouvement. C’est ce qu’a utilisé le parti flamand SP.A lorsqu’il a diffusé une vidéo truquée de Donald Trump appelant les Belges à sortir à leur tour de l’accord de Paris sur le climat. « C’est une méthode de marionnettiste. On n’a pas les expressions exactes de la personne », note Vincent Claveau.

Outils de détection

Pour tenter de démêler le vrai du faux face à de telles vidéos, plusieurs outils existent, notamment un plugin développé dans le cadre du projet InVID et déjà utilisé par 5 700 journalistes en Europe. « Les vidéos peuvent être segmentées en images clés ; à partir des moteurs de recherche, on cherche l’antériorité de l’image », explique Denis Teyssou de l’AFP. Reste qu’avec le deep learning, les technologies utilisées sont capables d’apprendre à contourner les détecteurs de faux. « Le réseau de neurones peut s’adapter en intégrant les éléments qui lui permettaient jusque-là de se faire détecter », résume Vincent Claveau. « Cela paraît difficile d’avoir un algorithme générique qui permette de détecter un artefact car si c’était le cas, il serait possible de le tromper », ajoute Mathieu Aubry.

Reste que pour Samuel Laurent, responsable des Décodeurs au Monde, les deepfakes ne sont aujourd’hui qu’« une réalité théorique ». « Techniquement, c’est possible, mais c’est de la prospective. Aujourd’hui, il n’y a pas de cas d’intox produit à partir de ça », insiste le journaliste. D’autant que selon lui, les fake news n’ont pas besoin de technologie pour proliférer : « C’est extrêmement facile d'abuser de la crédulité des internautes en termes d'information. Il n’y a pas besoin de s’embêter à imiter une voix pour faire croire quelque chose de faux. » Au-delà des outils techniques, que ce soit pour produire des deepfakes ou pour les détecter, l’éducation aux médias semble plus que jamais une priorité.

Lire aussi :